挑战:如何加速深度学习部署与优化

随着深度学习算法的不断创新,越来越多的应用需要对深度学习模型进行大规模和实时的分布式推理服务。虽然已经有一些工具可用于模型优化、服务、集群调度、工作流管理等相关任务,但是对于许多深度学习的工程师和科学家而言,开发和部署能够透明地扩展到大型集群的分布式推理工作流仍然是一个严峻的挑战。

为了便于构建和生成面向大数据的深度学习应用程序,英特尔推出了 Analytics Zoo 平台。该平台提供了统一的数据分析+ AI平台,可将TensorFlow、Keras、Pytorch、BigDl Spark、Flink和 Ray 程序无缝集成到一个统一的数据分析流水线中,用于分布式训练或预测,方便用户构建深度学习应用。整个流水线可以透明地扩展到运行在由搭载英特尔® 至强® 处理器的服务器组成的 Hadoop/Spark 集群上,以进行分布式训练或推理。

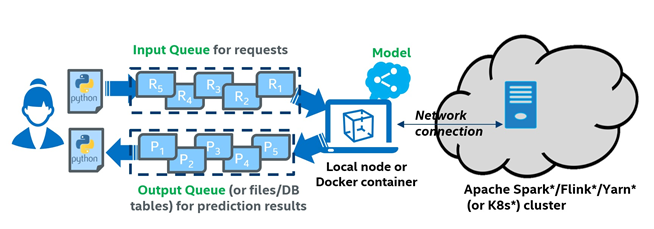

Analytics Zoo 在较新的版本中还提供了对于 Cluster Serving 的支持,构建了轻量级、分布式、实时的模型服务解决方案。Analytics Zoo Cluster Serving 支持多种深度学习模型,提供了一个简单的发布/订阅 API,可支持用户可轻松地将他们的推理请求发送到输入队列。然后,Cluster Serving 将使用分布式流框架在大型集群中进行实时模型推理和自动扩展规模。

图1. Analytics Zoo Cluster Serving 解决方案总体框架

要部署基于 Analytics Zoo Cluster Serving 的深度学习算法与应用,企业需要进行硬件选型、优化与验证,以提供高性能的算力支撑,但在此过程中,企业也面临着艰巨的挑战。首先,传统的解决方案并非是全栈设计,需要在硬件选型、软硬件适配与优化等方面耗费大量的时间与精力,也容易带来总体拥有成本 (TCO) 的上升。

其次,深度学习算法与应用对于 AI 性能有着很高的要求,未针对 AI 进行性能优化的 CPU 在运行效率上存在明显瓶颈。GPU 服务器虽然能够提供充足的算力支持,但是成本相对较高,应用范围受到较多的局限,而且其需要专门的部署与调优,不利于深度学习应用的快速上市。

解决方案:基于宝德 PR2715P2 AI 推理服务器的自动分布式可扩展推理平台

搭载第二代英特尔至强可扩展处理器的宝德 PR2715P2 AI 推理服务器全面支持Analytics Zoo Cluster Serving分布式推理技术方案。该推理服务器是一款软硬一体的分布式全栈推理解决方案,专为高性能计算、高级人工智能分析任务而设计,具有出色的性能功耗比。

图2:宝德 PR2715P2 AI 推理服务器

第二代英特尔至强可扩展处理器专为数据中心现代化革新而设计,能够提高各种基础设施、企业应用及技术计算应用的运行效率,进而改善总体拥有成本(TCO),提升用户生产力。它拥有更高的单核性能,能够在计算、存储和网络应用中,为计算密集型工作负载提供高性能和可扩展性。得益于英特尔® 通道互联(英特尔® UPI)、英特尔® Infrastructure Management 技术(英特尔® IMT)、英特尔® 高级矢量扩展指令集512(英特尔® AVX-512)等领先功能,它可满足严苛的 I/O 密集型工作负载的需求。

此外,第二代英特尔至强可扩展处理器内置人工智能加速,并已针对工作负载进行优化,能够为各种高性能计算工作负载、AI应用以及高密度基础设施带来的性能和内存带宽。同时,采用矢量神经网络指令(VNNI)的英特尔® 深度学习加速(英特尔® DL Boost)显著提高了人工智能推理的表现,与上一代产品相比,性能提升高达 14 倍。这使其成为拓展 AI 应用的卓越基础设施。

在宝德 PR2715P2 AI 推理服务器搭建的平台上,用户只需要准备 Analytics Zoo Cluster Serving 的 Docker Image、配置文件、训练好的模型(当前支持的模型包括TensorFlow、PyTorch、Caffe、BigDL和OpenVINO™的模型)及推理数据,即可在几分钟内启动并运行推理应用。

通过加入对于 Analytics Zoo Cluster Serving 的支持,宝德一体化分布式可扩展人工智能推理方案显著降低了配置和流程的复杂程度,在提供高级定制化服务的同时,有效降低了 TCO。这种全新的集群模型服务支持有助于简化用户的分布式推理工作流,提高工作效率,并为深度学习场景带来领先的性能。